最近DeepCrawlは、SMX Westに参加したSEO専門家やインフルエンサーに向けて簡単なTwitterを活用したインタビューを行いました。

質問内容の1つは、「SEOにおいて最大の課題は何ですか?」です。

さまざまな回答がありましたが、中でも多かった答え(35%)は、変化を続ける”ベストプラクティス”とアルゴリズムのアップデートに関する内容でした。

SEO領域を牽引する人々がSEOに関する各種最善の方法を模索している段階にあるとき、比較的知識が不足しているSEO担当者は容易に混乱してしまうことがよくあります。

SEOのための多くのブログやサイト、ウェビナーがありますが、、こうしたソースが提示する情報と”ベストプラクティス”の多くは時代遅れで効果がありません。Googleのアルゴリズムの定期的なアップデートと人々のオンライン検索様式の変化により、以前は有効だった古いSEO方法はもはやまったく機能しませんし、そもそも当時から全く役に立たなかった方法もあります。

これらの古いベストプラクティスはサイトの掲載順位に害を及ぼすものではないものの、これらの実装に投入するリソースは無駄であり、より効率的な最適化に使うべき貴重な時間を浪費してしまいます。

以下に19個紹介する、時代遅れとも言える”ベストプラクティス”を避け、サイトのパフォーマンスを改善する簡単な修正に注力しましょう。

1.meta keywordsタグ

一般的に信じられていることとは異なり、meta keywordsタグはページの検索エンジンの掲載順位において影響力がありません。むしろ、競合他社にサイトのキーワード戦略が知られてしまうため、これを行うことは避けましょう。

2.Googleニュースサイトマップ内の画像URL

Googleニュースサイトマップは画像に対応していません。XMLサイトマップであれば問題ないかと思いますが、通常、Googleニュースサイトマップでは除外した方が良いでしょう。

Googleニュース記事の側に個別のサムネイル画像を表示させたい場合は、og:imageやschema.orgを使用してみてください。Googleはこの方法を推奨しています。

3.過剰なリンク

これはやめましょう。バックリンクは以前は非常に強力な要素でしたが、SEOに詳しい人は量より質が最近は重要になってきていることを知っており、現在ではリンクを盲目的に増やすことはほんの一部の人しか行っていません。Googleのペンギンアップデートでアルゴリズム変更が行われた結果、掲載順位にリンクの数はさほど重要でなく、オーソリティと価値のあるリンクの重要性が高まりました。リンクを行うページを探してスクロールするのをやめ、その代わりにコンテンツへ価値を加える重要なリンクに焦点を当てるようにしましょう。

4.アプリのディープリンクやHreflangタグに正規化されたURLを指定している

これは危険です。hreflangタグに正規化されたURLを指定している場合、検索エンジンがそのURLをクロールできない可能性があります。正規化URLを使用する際はアプリのディープリンクやhreflangタグ内にのみ配置されるようにしましょう。

5.Robots.txtファイルの”index”ディレクティブと”Follow”タグ

“follow”タグや”index”ディレクティブを使用している場合、検索エンジンに通常通り動作するよう余計な指示を加えることになります。したがって、これらのディレクティブやタグの追加は、サイト上のコードをわかりづらくするとともに時間の浪費にしかなりません。

6.順位表示を目的とした小手先のキーワード配置

過去、ブログ記事やページにキーワードが散在し、キーフレーズが幾度となく繰り返されていた時期がありましたが、そうした日々は過去のものとなっています。Googleは最近、潜在的意味解析(Latent Semantic Indexing(英語))を使用するようになり、クローラーが単語やフレーズの文脈を理解できるようになってきています。検索順位を上げるために未だに特定の単語に焦点を当てている場合、キーワードスタッフィングの概念から離れ、類語辞典を使用するようにしてより最適なコンテンツ制作を行うようにしてください。

7.Robotsのクロール遅延

GoogleはGooglebotのディレイを採用していませんが、Bing向けには使用を検討しても良いかもしれません。Googlebotのクロール頻度を制限したい場合、サーチコンソール>サイト設定>クロール頻度で設定を行うことができます。

8.Disallowでのインデックス拒否

ページがDisallowで指定されていたとしてもインデックスされます。検索エンジンはそのページをクロールできないものの、その他のページからリンクされている場合にはインデックスし続けます。これは内部リンク、外部リンクにかかわらず発生します。

9.スマートフォン向けサイトマップ

モバイルサイトマップはフィーチャーフォン向けのページのみに使用されるため、スマートフォンに互換性のあるページにはモバイルサイトマップは適用されません。スマートフォンとデスクトップのURLが異なる場合、デスクトップURL専用の、通常のXMLサイトマップを使用して、スマートフォン向けURLにはrel=alternateを使用してください。

詳細は、2014年11月のウェブマスターハングアウト(英語)をご覧ください。

10.ソーシャルメディアを活用しない

”#ing”や”Like (いいね)”の価値を把握することは難しいものである一方、サイトの信頼性の指標としてのソーシャルメディアは疑う余地なく、無視すべきものではありません。ソーシャルプロフィールを作成すると、人々がサイトを好んで利用しているという情報をGoogleやその他検索エンジンに対して与えます。

11.ページランクの公開

2014年10月に、Googleは公開されるページランクの値を以降更新していかないことを示しました(英語)。実際、この値は2013年10月から更新されていませんでした。

12.アルゴリズムペナルティへの再審査リクエスト

再審査リクエストについて、サイトが手動での対応に影響を受けた場合のみ送信するべきであるとの見解をGoogleは示しています(英語):

「サイトのビジビリティがアルゴリズム変更のみによって影響を受けた場合、取り消す対象の手動対応がないため、再審査リクエストを送信する必要はありません。」

リンクスパムやその他の迷惑行為によるGoogleのペンギンアップデート時のアルゴリズムペナルティは、原因が取り除かれた場合、次のアルゴリズムの更新時にのみ解除されます。

Search Engine Landはアルゴリズムペナルティの検出と修正に役立つガイド(英語)を公開しています。

13.Disallowとmeta noindex

Disallowとmeta noindexは、ページのインデックスとクロールを防ぐ目的でしばしば間違った組み合わせで使用されます。これは、ページが既にrobots.txt内でDisallwされているページでは非効率的です。これは、いずれにせよ検索エンジンのクローラーがページをクロールしないためです。

14.XMLサイトマップの Change FrequencyとPriority

GoogleのJohn Mueller氏は、GoogleはXMLサイトマップにおけるChange Frequency (更新頻度)とPriority (優先度) を頻繁に使用しないと述べ、その代わりに変更日を送信するよう提言しました。更新を完了するためには、lastmodタグで最終更新日を記述してください。

15.コメントスパム

かつてはコメントがリンク構築の役割で使用されてましたが、今日では、サイトのリンクを添えてコメントすることで時間を使うのは無駄な仕事です。 Googleが”nofollow”タグを導入したことで、サイト管理者はクローラーに対してコメント欄のリンクを無視するよう指示できるため、コメント欄に手当たり次第リンクを残してもSEOの役には立ちません。

16.Robots.txt内のサイトマップURL

Robots.txt内において、サイトマップのURLは絶対URLである必要があります。サイトマップが相対URLの場合、検索エンジンのクローラーから無視されてしまいます。

サーチコンソールでrobots.txtをテストしましょう。問題がある場合、”無効なサイトマップURLが検出されました:シンタックスが不明です”という警告が表示されます。

17.サイトの登録

Googleやその他の検索エンジンはサイトのインデックスに非常に優れています。サイトを作成すればボットが巡回に来るといったように、Googleにサイトを登録する必要はなく、Googleがサイトを検出してくれます。

18.[site:]コマンド

Googleがインデックスしているサイトのページ数の確認方法(英語)/span>:サーチコンソールの”インデックスステータス”と”サイトマップインデックス数”を確認してください。

info:queryを使用すると、GoogleがインデックスしているURLのバージョンを確認できます。GoogleのJohn Mueller氏は、この方法を”インデックス登録のために実際に取得しているURLを確認する大雑把な方法”であると述べています。

19.モバイル向けのVary HTTP

ページコンテンツが劇的に変化する場合、Vary HTTPヘッダの使用のみ必要となります。動的なコンテンツ変動のあるモバイル専用URLにおいて、ユーザーエージェントに基づいて様々なコンテンツを提供する場合、Vary HTTPヘッダーは不要です。

詳細については、こちらのウェブマスターハングアウト(英語)をご覧ください。

回避するべきSEO施策を理解した上で、何から始めれば良いか?

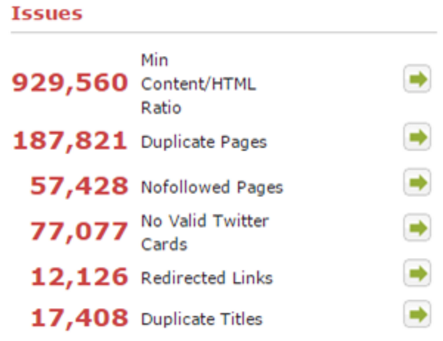

DeepCrawl独自のランク機能であるディープランクを確認してみてください。

ディープランクとは、Googleの基本的なページランクアルゴリズムと似た方法で算出された内部リンクのウェイトを表す指標です。ほとんどすべてのDeepCrawlのレポートはディープランクの順序に並んでいるため、優先度が高い問題は常に上部に表示されることになります。