なぜURLの重複がサイトに有害であり、それをいかに止めるか?

URLの重複は、同じサイト内の複数のURLが全く同じページを表示することです。例えば、以下のような例があります。

/news.aspx と/news.html>

/contactと/CONTACT

/news?source=rssと/news?source=header

多くのサイトでは異なるURLから同じページが表示されることが許可されていますが、Googleはこれらを同一のコンテンツを含む異なったページであると理解します。

なぜURLの重複が問題なのか?

同じページの異なるバージョンをGoogleにクロールさせることはクロール効率を下げ、そのページの各バージョンに関してオーソリティシグナルを希薄化させることになるため、結果として潜在的なパフォーマンスを制限してしまいます。

こうしたURLの重複に起因する諸々のリスクを避ける方法があります。まずは、よくある6つの事例を見てみましょう。

サイトが問題を抱えている?重複したURLのよくある事例

1. 様々なURLの末尾

- /news

- /news/

- /news.html

- /news.aspx

- /news/home/

URLの重複を避ける方法

2. 大文字の使用に一貫性がない

- /news

- /News

- /NEWS

3. 同じURLパスが繰り返されている

- /news/

- /news/news/

4. パラメーターの順番が逆になっている

- /news?page=1&order=recent

- /news?order=recent&page=1

5. 任意で追加されているURLパスがある

- /news/

- /news/home/

6. トラッキングパラメーターからの重複

パラメーターはトラッキングには非常に有効でありページのコンテンツを変更しますが、それぞれのURLは同様の結果を戻すことになりこれが重複を意味します。

- /news?source=header

- /news?source=footer

- /news?source=rss

URLの重複を避けるには、内部リンクにおいて一貫したURLフォーマットを使うことが最善の方法となります。1つの内部リンクをピックアップして、そのフォーマットに統一しましょう。その上で、サイトに内部リンクを追加する場合は常にこのフォーマットに従うようにしてください。

重複問題に対処する最善の方法

すでに重複問題が発生してURLの重複が多く存在する場合

すでに重複問題が発生してURLの重複が多く存在する場合には、内部リンクをアップデートするだけでは対策として十分ではないかもしれません。というのも、GoogleがいったんURLを検出すると、そのリンクが削除されてからもクロールし続けるからです。

まずは、301リダイレクトの問題を解決し、ユーザーが正しいコンテンツのバージョンにアクセスできるように、またGoogleが正しいURLをインデックスできるようにしましょう。

その後URLの重複を未然に防ぐために以下の対策を実行してください。

- 各ページにcanonicalタグを実装してGoogleにどのURLそのページの正規URLか伝える。

- お使いのウェブマスターツールのパラメーター設定を変更して、固有のコンテンツを生み出していないパラメーターを除外する。

- クロールの効率性を向上させるために、robots.txtの不適切なURLを許可しない。

将来的に問題が発生することを避けるため、全ての内部リンクを同様のフォーマットで追加するようにしてください。サイトに内部リンクを追加できる権限を持つメンバーに対して、URL重複が引き起こすリスクをインプットし、全てのメンバーが同じフォーマットを踏襲するようにしてください。

なぜこれら全ての解決策を同時に行う必要があるのか?

残念ながら全ての重複したURLの問題に対する唯一の解決策というものはありません。それぞれの解決策にはメリットとデメリットがあるため、これらを合わせて実行することが全ての潜在的な問題をカバーするにあたり最も良い方法となります。

301リダイレクトにより重複ページがインデックスされることを避け、オーソリティシグナルを統合することができるので、過去の重複問題を解決するのに役立ちます。

一方で内部でリンクされたURLをリダイレクトすることはクロールの効率性を阻害するため、301リダイレクトは既存の重複問題を解決する場合にのみ適切と言えます。リダイレクトURLへの内部リンクをアップデートするのが最善の方法です。

DeepCrawlは全ての内部リダイレクトURLに関するレポートを提供しており、リダイレクトURLへ直接リンクされているURLをアップデートすることができます。

Canonicalタグを利用すると主要ページへのオーソリティシグナルを統合し、パフォーマンスに影響する問題を解決できますが、Googleがcanonicalタグを検出するために全てのURLをクロールしなければならないためにクロールの効率性を向上することはできません。正規化ページに大量の重複URLがある場合、canonicalタグがあってもサイトがクロールできない可能性があります。

DeepCrawlはcanonicalタグ設定に関する幅広いレポートを提供しており、設定者の意図する通りにcanonicalタグが確実に機能するようにできます。

ウェブマスターツールの設定はパラメーターの重複問題を効率的に解決できますが、GoogleとBingのみ利用できるため、FacebookやTwitterに関連する問題を解決することはできません。

robots.txt内部の重複したURLを許可しない設定にすれば、重複がクロールされなくなるためクロールの効率性を高めることができます。

しかし、重複した各ページのオーソリティを決定するためにクロールされないので、この方法では重複した各ページのオーソリティシグナルを統合することができません。

DeepCrawlではrobot.txtファイルのために許可されていない全てのURLに関するレポートを提供しています。DeepCrawlを使って効果をシミュレーションし、新しいrobot.txtファイルを検証することができます。

URLの重複が発生していると判断するには?

他の重複と同様に、URLの重複はサイトパフォーマンスを阻害する要因となるため、しっかりと検出して問題があれば修正することが重要となります。

しかし、こうした問題が発生していると判断し、どのURLが問題を引き起こしているか見つけるにはどうすれば良いのでしょうか?Googleウェブマスターツールにはこうした情報は表示されず、全てのURLのバリエーションを確認するのは不可能です。

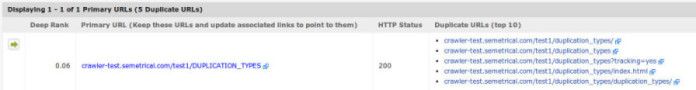

DeepCrawlの強力な重複ページレポートを使えば、サイト上の重複したURLのアラートを出し、そのページの主要URLを検出し、どのページが重複しているかというところまで把握できるため、すぐに問題の解決策を考えはじめることができます。